Documentación: Problemas y desafíos de la gestión de datos dentro de una organización

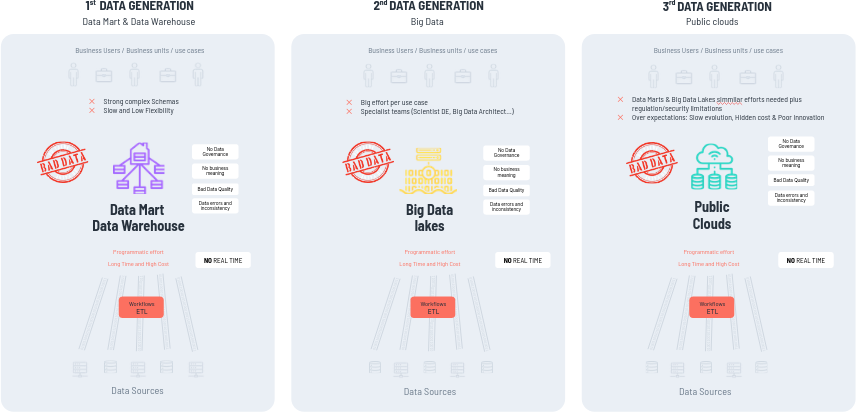

2. Evolución general de la Gestion de Datos

2.1. Problemas y Limitaciones

Cualquier prouyecto que solicita un cliente hoy en día se está haciendo con una de estas tecnologías:

- DataMart / DataWarehouse

- Big Data Lakes

- Public Clouds

Las generaciones tradicionales presentan limitaciones significativas:

- Hemos tenido contenedores de datos físicos donde los datos se copiaban de manera física.

- El movimiento de datos generalmente se realiza mediante flujos de trabajo y ETL (Extraer, Transformar, Cargar), que son esencialmente programas.

- La creación de informes, modelos, etc., debe ser desarrollada con programas.

Cuando las personas tienen que realizar todas estas tareas, especialmente en el contexto de la inteligencia artificial, no resulta rentable. Estas tareas son tediosas, consumen mucho tiempo y no aportan valor desde la perspectiva de un profesional.

Por eso, se requiere tecnología para acelerar y automatizar estos procesos, lo que permite a los profesionales centrarse en tareas que requieren inteligencia humana y aportan valor.

IMPORTANTE: Gestionar los datos solo con personas no funciona, procesos muy lentos y mucho coste.

__________________________________________________________________________________________________________________________________________________

- PROBLEMA 1

El problema de las ETL es que hacer programas para mover datos de un sitio a otro requiere tiempo y por otro lado estructuralmente no disponibiliza los datos en "real-time", en los workflows se suelen mover los datos en un determinado momento programado. Por lo que los sistemas de inteligencia artificial no pueden reaccionar en tiempo real para proporcionar un mejor servicio a las empresas.

- PROBLEMA 2

En los DataMarts los esquemas agregados, cubos y dimensiones son muy rígidos, se tarda mucho tiempo en cambiar algo, son muy poco flexibles.

En los proyectos de Big Data hay que hacer un proyecto por caso de uso porque los datos se arrojan sin más y el equipo de ingenieros de datos, científicos de datos, tienen que trabajar mucho los datos para hacer un determinado proyecto/caso de uso. (Artesanía de la algoritmia)

En los public cloud tengo infraestructura elástica pero si quiero hacer un Datamart o un Lago tengo el mismo problema.

- PROBLEMA 3

Otro problema es que si movemos los datos de nuestro sistema de gestión/información/operacional de origen a un Datamart o un Lago , cuando los sacamos de estos sistemas, como las funcionalidades de esos ERPS le daban significado de negocio a los datos en cuanto copiamos y/o movemos los datos a otros sistemas, se quedan sin significado empresarial. Por lo que si no se Gobierna, no tendrá significado de negocio, tendrá problemas de calidad y errores.

Por lo que si el dato es malo el valor que obtengo es bajo o el esfuerzo que tengo que hacer para obtener valor de ellos es muy grande.

- PROBLEMA 4